과금이 처음이라면 무섭지만, 두 번째라면 덜 무섭달까요..?

소플의 처음 만난 AWS를 다 읽고 AWS 교과서까지 다 읽었습니다.

개인적으로 난이도는 교과서가 더 높은 것 같아서 AWS가 처음이시라면 가볍게 소플의.. 를 읽고 나서 조금 더 자세히 알아보기위해 교과서까지 같이 보시면 좋은 것 같습니다. 특히 네트워크 부분이 기초를 쌓기에 좋다고 생각합니다.

AWS 과금이 될 수도 있다는 몇몇 구간이 있었는데, 다음날 반영되다보니 프리 티어인데 어떤 이유로 과금되었는지 기억이 안나더라구요.

그래서 책을 다 읽은 김에 한 번에 정리해봅니다,,

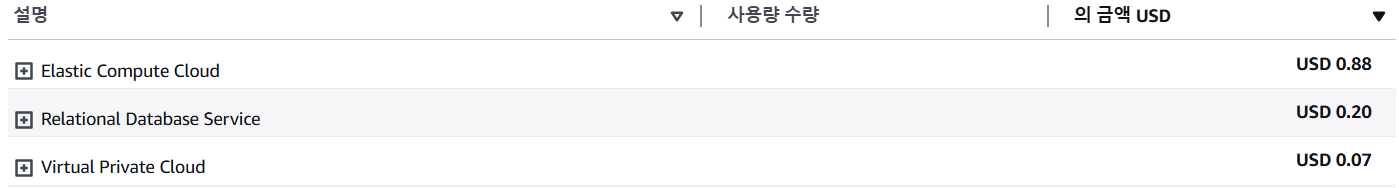

지난 번과 유사하게 EC2와 RDS와 VPC가 원인으로 들어가 있군요..

1. EC2

Amazon Elastic Compute Cloud NatGateway

- $0.059 per NAT Gateway Hour: 2 Hrs

Nat(Network Address Translation)Gateway: 네트워크 주소 변환 서비스

* 프라이빗 서브넷에서 외부 인터넷으로 통신하는 관문 역할

* 프라이빗 서브넷은 외부 인터넷 구간과 단절된 독립된 네트워크이지만 외부 인터넷 구간과 통신이 필요할 때는 NAT 게이트웨이를 통해 프라이빗 IP 주소를 퍼블릭 IP 주소로 변환하여 외부 인터넷 구간과 통신할 수 있음

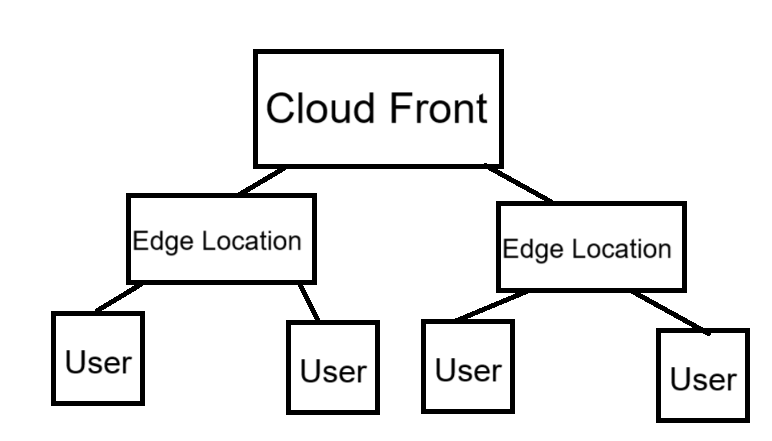

AWS 네트워크 서비스를 공부할 때, 아래와 같은 구조를 테스트해 보기 위해 NAT Gateway를 생성했습니다.

| 출발지 | 목적지 | 통신 가능 여부 |

| 퍼블릭 서브넷 | 외부 인터넷 | 가능 |

| 외부 인터넷 | 퍼블릭 인터넷 | 가능 |

| 프라이빗 인터넷 | 외부 인터넷 | 가능 |

| 외부 인터넷 | 프라이빗 인터넷 | 불가능 |

Amazon Elastic Compute Cloud running Linux/UNIX

- $0.052 per On Demand Linux t3.medium Instance Hour: 14.6 Hrs

찾아보지 않아도 알 수 있습니다.

제가 프리티어에서 무료로 사용할 수 있는 인스턴스 유형이 아닌 t3.medium 인스턴스를 썼기 때문이죠^^..

* 프리티어는 t2.micro 또는 t3.micro 인스턴스가 한달에 750시간의 사용 시간이 제공됩니다.

2. RDS

Amazon Relational Database Service for MySQL Community Edition

- USD 0.052 per db.t3.micro Multi-AZ instance hour (or partial hour) running MySQL: 1.276 Hrs

기억이 납니다. 기억이..

FailOver 테스트를 해볼 때였을까요..

Multi AZ는 고가용성을 위해 데이터베이스를 두 개의 가용 영역(AZ)에 걸쳐 복제하는 옵션인데, 추가 비용이 있습니다.

Amazon Relational Database Service Provisioned Storage

- $0.131 per GB-month of provisioned GP3 storage running MySQL: 0.292 GB-Mo

RDS 설정했을 때, 스토리지 유형을 GP3로 설정하면 나옵니다.프리티어 친구들은 GP2를 사용해야 합니다.* provisioning: 사용자가 요청한 IT 자원을 사용할 수 있는 상태로 준비하는 것

Amazon Relational Database Service Provisioned Storage

- $0.262 per GB-month of provisioned GP3 storage for Multi-AZ deployments running MySQL: 0.354 GB-Mo

단위 당 비용이 가장 비싼 친구^^...

Multi-AZ용 GP3 스토리지 요금입니다.

다른 가용영역에 예비 DB 인스턴스를 배포시킨 대가입니다..

3. Virtual Private Cloud

Amazon Virtual Private Cloud Public IPv4 Addresses

- $0.005 per In-use public IPv4 address per hour: 14.329 Hrs

저번에도 한 번 청구되었던 기억이 나네요..

하지만, 이번에는 직접 원인을 찾아가보는 과정을 추가해보겠습니다.

VPC → Amazon VPC IP Address Manager → 퍼블릭 IP 인사이트(과금의 원인에 대한 인사이트를 주겠다는 의미일까요..)

EC2가 아닌 서비스가 범인이며, 저의 경우에는 RDS였습니다.

다시 한 번 옮겨 적어보는 문의 사항에 대한 답변..

프리티어를 사용하고 계실 경우, EC2용 퍼블릭 IPv4 주소에 대해 월 750시간의 무료 혜택이 제공되지만, 안타깝게도, RDS와 같은 다른 서비스와 연결되어 사용된 퍼블릭 IPv4 주소에 대해선 프리티어 혜택이 제공되지 않습니다.

📑참고 자료

Chat GPT

https://kimjingo.tistory.com/180

[AWS] VPC NAT Gateway 구성하기

AWS에서 NAT Gateway란? NAT 게이트웨이는 NAT(Network Address Translation, 네트워크 주소 변환) 서비스입니다. 프라이빗 서브넷의 인스턴스가 VPC 외부의 서비스에 연결할 수 있지만 외부 서비스에서 이러한

kimjingo.tistory.com

https://jaeyumn.tistory.com/342

[AWS] Amazon Relational Database Service Provisioned Storage 비용

AWS로 서버를 설정하고 배포한 후 청구서에 비용이 조금씩 올라가기 시작했다. $0.131 per GB-month of provisioned GP3 storage running MySQL 이 녀석이 문제였다. 지금은 $0.00 per GB-month of provisioned GP2 storage under m

jaeyumn.tistory.com

https://shortcuts.tistory.com/53#google_vignette

[해결] AWS 퍼블릭 IPv4 유료화: 프리티어인데 과금되었다면

2024년 2월 1일부터 AWS의 Public IPv4 주소 사용이 유료화되었다. https://aws.amazon.com/ko/about-aws/whats-new/2024/02/aws-free-tier-750-hours-free-public-ipv4-addresses/ IPv4 주소가 고갈되면서 IPv6로의 이전을 장려하기 위

shortcuts.tistory.com

'PlayGround > AWS 연습' 카테고리의 다른 글

| [AWS] AWS SDK, CLI (1) | 2025.04.10 |

|---|---|

| [AWS] Lambda (0) | 2025.04.09 |

| [AWS] DynamoDB (0) | 2025.04.08 |

| [AWS] CloudFront (0) | 2025.04.07 |

| [AWS] S3 (1) | 2025.04.06 |